在科技界风起云涌的今天,Reddit的最新动态再次引发了广泛关注。这家知名的在线社区平台,在与谷歌达成价值6000万美元的AI内容授权协议后,近期却被曝出屏蔽了多个搜索引擎和AI爬虫的访问权限。这一举动迅速成为科技圈热议的焦点,而Reddit官方则迅速出面澄清,表示此举与谷歌的合作并无直接关联。

今年2月,谷歌与Reddit携手宣布了一项重量级合作——Reddit的数据将用于训练谷歌的AI模型,并在谷歌搜索结果中优先展示Reddit的内容。这一合作不仅彰显了Reddit在内容质量上的高度认可,也预示着AI技术在内容分发领域的进一步应用。然而,好景不长,近期Reddit的一系列操作却让外界感到意外。

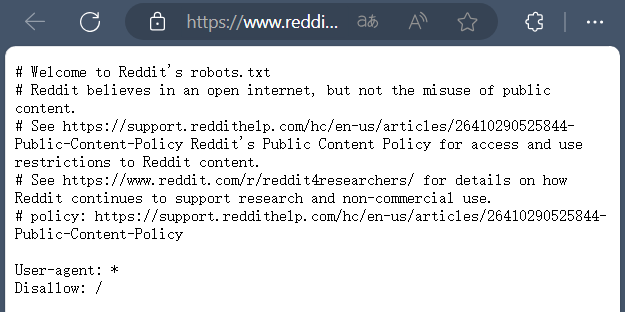

据外媒404 Media报道,Reddit已经悄然更新了其robots.txt文件,这一协议文件是网站与爬虫之间的重要沟通桥梁。Reddit在文件中明确设置了“Disallow”选项为“/”,意味着禁止所有机器人抓取网站根目录下的任何内容。这一举动立即引发了业界的广泛猜测和讨论,许多人认为Reddit这是在保护自己的内容不被滥用,但也有声音质疑这是否会阻碍信息的自由流通。

面对外界的种种猜测和质疑,Reddit官方迅速出面澄清。Reddit发言人Tim Rathschmidt在给The Verge的声明中表示:“此次内容封锁与我们最近与谷歌的合作完全无关。”他进一步解释道,Reddit一直在与多个搜索引擎进行积极的沟通和讨论,但由于某些搜索引擎无法或不愿意就内容使用(包括AI训练)作出可执行的承诺,因此Reddit不得不采取这一措施来保护自己的内容生态。

Reddit此次内容封锁的背后,实际上是内容生态保护与商业利益之间的权衡与博弈。随着互联网的快速发展和AI技术的广泛应用,内容抓取和滥用的问题日益凸显。对于Reddit这样的在线社区平台而言,如何在保护用户隐私和版权的同时,又能确保内容的自由流通和有效分发,成为了一个亟待解决的难题。

Reddit在解释其决策时提到,“抓取Reddit内容的商业实体明显增多并且内容被滥用”,这无疑是促使他们采取行动的重要原因。通过更新robots.txt文件来阻止未经授权的爬虫访问,可以在一定程度上减少内容被滥用的风险,保护用户和创作者的权益。

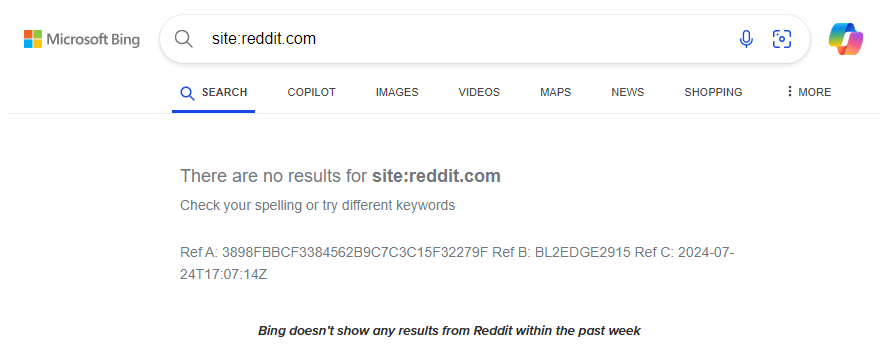

对于受到影响的搜索引擎而言,这无疑是一次不小的挑战。然而,值得注意的是,在Reddit更新robots.txt文件后不久,Bing、DuckDuckGo等搜索引擎已经通过技术手段重新恢复了部分Reddit内容的搜索功能。这表明,搜索引擎正在积极应对这一变化,努力寻找与Reddit等在线社区平台合作的新模式。

AI旋风认为,此次事件也为整个互联网行业敲响了警钟。在追求商业利益的同时,必须尊重和保护用户及创作者的权益,共同维护一个健康、有序的网络生态环境。未来,随着AI技术的不断进步和法律法规的日益完善,我们有理由相信,内容生态的保护与商业利益的平衡将会得到更好的实现。