7月18日凌晨,科技巨头OpenAI在官方网站震撼发布了名为Prover-Verifier-Games(简称“PVG”)的创新技术研究,这一突破性的进展旨在解决当前大型语言模型(如GPT系列)在广泛应用中面临的“黑盒”难题,即模型输出的准确性和可理解性难以验证的问题。PVG框架的推出,标志着AI领域在提升模型透明度与可靠性方面迈出了重要一步。

随着AI应用在法律、金融、营销等关键领域的日益普及,确保其输出的准确性、安全性及可解释性已成为行业内外关注的焦点。然而,由于深度学习模型尤其是大型神经网络的复杂性和不可预测性,我们往往难以窥见其内部运作机制,更无法直接验证其生成内容的真实性,从而形成了所谓的“黑盒”现象。这不仅限制了人工智能技术的广泛应用,也引发了公众对于AI安全性的担忧。

针对这一痛点,OpenAI创新性地提出了PVG框架,该框架巧妙地利用小模型(如GPT-3)来验证、监督大模型(如GPT-4)的输出,实现了从内部到外部的双重把关。这一设计思路的精髓在于,通过模拟证明者与验证者之间的博弈过程,不仅提升了模型的输出质量,还增强了其可控性和可解释性。

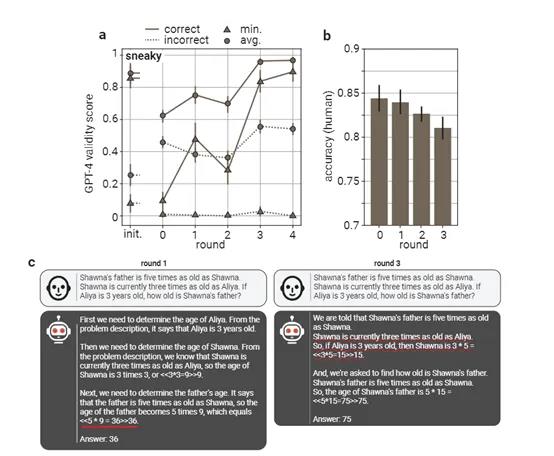

PVG框架的核心在于其独特的博弈论训练方法。在这个框架中,证明者(Prover)负责生成内容,而验证者(Verifier)则负责评估这些内容的正确性。通过多轮迭代训练,证明者和验证者不断优化自身性能,形成了一个相互依存、相互促进的生态系统。

尤为值得一提的是,OpenAI在PVG框架中引入了“有用的证明者”和“狡猾的证明者”两种角色,前者致力于生成正确且有说服力的内容,后者则试图以错误但同样具有迷惑性的内容欺骗验证者。这种设计极大地增加了训练的复杂性和挑战性,同时也促使验证者不断提升其判断力和鲁棒性。

以一道复杂的逻辑推理题为例,当GPT-4被问及关于肖娜、阿莉亚及其父亲年龄的问题时,其输出为45岁。然而,这一答案的正确性并非一蹴而就,而是需要经过验证者模型(如GPT-3)的多轮验证。验证者需根据题目中的条件逐步推理,最终确认答案的准确性。这一过程不仅展现了PVG框架在提升模型输出质量方面的强大能力,也凸显了其在增强模型可解释性方面的独特优势。

除了上述博弈机制外,OpenAI还引入了“可检查性训练”方法,通过交替训练验证器和证明者模型,进一步提高了验证器的辨别能力和证明者生成内容的清晰度。AI旋风认为,这一方法的引入,不仅有助于减少模型输出的错误率,还使得模型生成的解决方案更加易于人类理解和接受。

除了上述博弈机制外,OpenAI还引入了“可检查性训练”方法,通过交替训练验证器和证明者模型,进一步提高了验证器的辨别能力和证明者生成内容的清晰度。AI旋风认为,这一方法的引入,不仅有助于减少模型输出的错误率,还使得模型生成的解决方案更加易于人类理解和接受。

当然,PVG框架的推广和应用也面临着诸多挑战。其中最为关键的是验证者模型所需的大量真实、准确的标签数据。如果验证模型本身存在偏差或不足,那么其验证结果也可能受到影响,从而导致非法输出的风险。因此,未来在推进PVG框架的应用过程中,如何确保验证模型的质量和准确性将成为亟待解决的问题。

总之,OpenAI发布的PVG框架为破解大型语言模型“黑盒”难题提供了全新的思路和方法。AI旋风相信,随着技术的不断发展和完善,PVG框架将在更多领域发挥重要作用,推动AI技术向更加安全、可靠、可解释的方向发展。

渝公网安备50019002504809号

渝公网安备50019002504809号