在人工智能领域,每一次技术创新都如同飓风般席卷而来,推动整个行业向前跃进。MobileLLM,一个专为智能手机及其他资源受限设备设计的紧凑型语言模型,其参数规模仅为3.5亿,标志着AI模型小型化、高效化发展的新篇章。

2024年6月27日,Meta AI正式发布MobileLLM项目,不仅是对传统AI模型规模认知的一次勇敢挑战,更是对未来AI应用场景的一次深刻洞察。在这个大数据与高性能计算并行的时代,MobileLLM以其独特的设计理念和技术创新,为我们展示了如何在有限的资源条件下,实现AI模型的高效运行与卓越性能。

此次MobileLLM的研发团队汇聚了Meta Reality Labs、PyTorch以及Meta AI Research(FAIR)的精英力量,他们携手并进,专注于优化参数规模在10亿以下的模型。与动辄万亿参数的GPT-4等巨无霸模型相比,MobileLLM的参数量虽显“小巧”,但其背后的技术含量与创新价值却不容小觑。

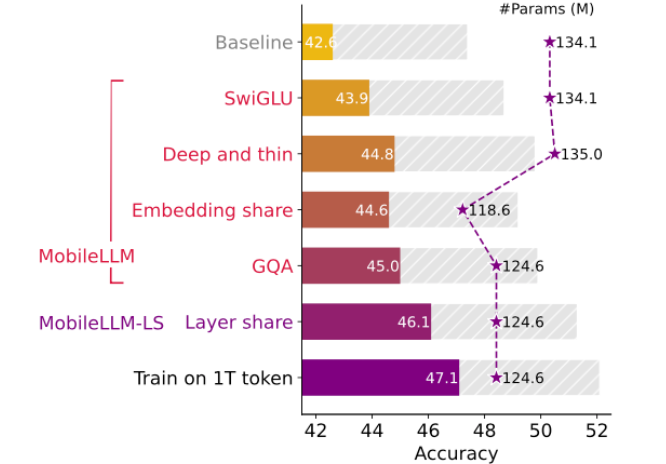

MobileLLM的核心创新在于其独特的设计哲学——优先考虑模型深度而非宽度。这一策略使得MobileLLM能够在不牺牲性能的前提下,大幅减少参数数量,从而在资源受限的环境中展现出非凡的语言处理能力。AI旋风了解到,通过嵌入共享和分组查询注意机制,以及一种新颖的直接块权重共享技术,MobileLLM在多个基准测试任务上的表现均优于同类规模的模型,性能提升幅度达到2.7%至4.3%。这些看似微小的进步,实则是语言模型开发领域的一次重大飞跃,彰显了Meta AI团队在技术创新方面的深厚功底。

尤为值得关注的是,在某些API调用任务中,MobileLLM的3.5亿参数版本竟然展现出了与70亿参数LLaMA-2模型相当的准确率。这一发现不仅颠覆了我们对模型规模与性能之间关系的传统认知,更为我们指明了未来AI模型发展的新方向:即对于特定应用场景而言,更紧凑的模型同样能够提供高效且准确的服务,从而极大地降低了部署成本和资源消耗。

虽然MobileLLM目前尚未面向公众全面开放,但Meta AI已经将其预训练代码开源,邀请全球范围内的研究人员共同参与这一项目的后续研究与开发。这一举措不仅彰显了Meta AI在推动AI技术进步方面的开放态度,更为整个AI领域构建了一个更加繁荣、共享的生态系统。随着MobileLLM技术的不断成熟与完善,我们有理由相信,它将在未来为个人设备带来更加先进、智能的AI功能体验。

Meta AI推出的MobileLLM紧凑型语言模型,不仅是对现有AI模型规模的一次大胆挑战,更是对未来AI应用场景的一次深刻洞察与前瞻布局。随着技术的不断进步与应用的不断拓展,我们有理由相信,MobileLLM将引领AI模型小型化、高效化发展的新潮流,为人类社会带来更加便捷、智能的生活方式。让我们共同期待这一天的到来!