在人工智能技术的浩瀚星空中,又一颗璀璨的明星悄然升起。7月12日,科技界的创新先锋智谱AI震撼宣布,他们已成功训练并开源了新一代视频理解模型——CogVLM2-Video,这一突破性的进展不仅为视频智能分析领域带来了革命性的变化,更在回答时间相关问题上展现了前所未有的精准度与泛化能力,标志着AI在视频理解领域的又一次飞跃。

随着视频内容的爆炸式增长,如何高效、准确地从海量视频中提取有价值信息,尤其是与时间紧密相关的细节,成为了业界亟待解决的难题。传统视频理解模型多依赖于帧平均和视频标记压缩等简单处理方式,这种方法在追求处理效率的同时,却不可避免地牺牲了时间维度的精细信息,导致模型在回答“何时发生?”、“持续了多久?”等时间相关问题时显得力不从心。而智谱AI此次推出的CogVLM2-Video模型,正是针对这一痛点所设计的“解药”。

据智谱AI介绍,CogVLM2-Video的核心竞争力在于其独特的训练数据集构建方法和模型架构设计。面对时间问答数据稀缺且质量参差不齐的现状,智谱AI创新性地提出了一种基于视觉模型的自动时间定位数据构建方法,这一方法如同一位智能剪辑师,能够精准地从海量视频素材中捕捉并标注出与时间紧密相关的关键片段,最终生成了包含3万条高质量时间问答数据的专属数据集。这一举措不仅极大地丰富了训练数据的多样性,也为模型学习时间敏感特征奠定了坚实的基础。

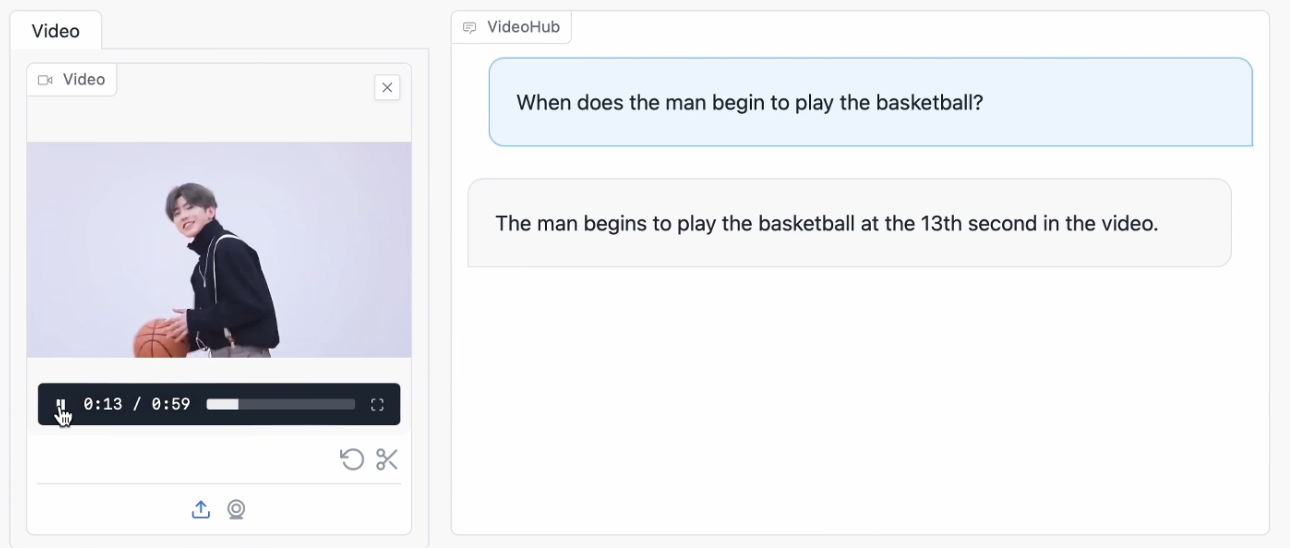

在此基础上,CogVLM2-Video模型采用了创新的编码器设计,首次将多帧视频图像及对应时间戳作为输入,通过深度神经网络的有效融合,实现了对视频内容及时间维度的全面理解。这种设计不仅保留了视频的空间信息,还捕捉到了时间流逝的微妙变化,使得模型能够更加准确地理解视频中的时序关系和动态事件,从而在回答时间相关问题时展现出卓越的性能。

据了解,CogVLM2-Video在多个公共视频理解基准测试中均取得了令人瞩目的成绩,不仅刷新了多项性能指标,还在视频字幕生成和时间定位等具体任务上展现出了强大的实力。这意味着,无论是自动为视频添加精准的时间戳注释,还是根据用户提问快速定位视频中的特定时刻,CogVLM2-Video都能游刃有余地应对。

更为重要的是,CogVLM2-Video的开源之举,无疑将极大地推动视频理解技术的普及与发展。开发者们可以基于这一模型进行二次开发,探索更多创新应用场景,如智能监控、视频内容审核、教育视频辅助学习等,为各行各业带来前所未有的便利与效率提升。

智谱AI此次推出的CogVLM2-Video模型,不仅是对视频理解技术的一次重大突破,更是AI技术向更高层次智能化迈进的坚实步伐。随着该模型的广泛应用与不断优化,我们有理由相信,未来的视频世界将更加智能、更加便捷,而时间将成为我们探索视频内容深度与广度的又一重要维度。