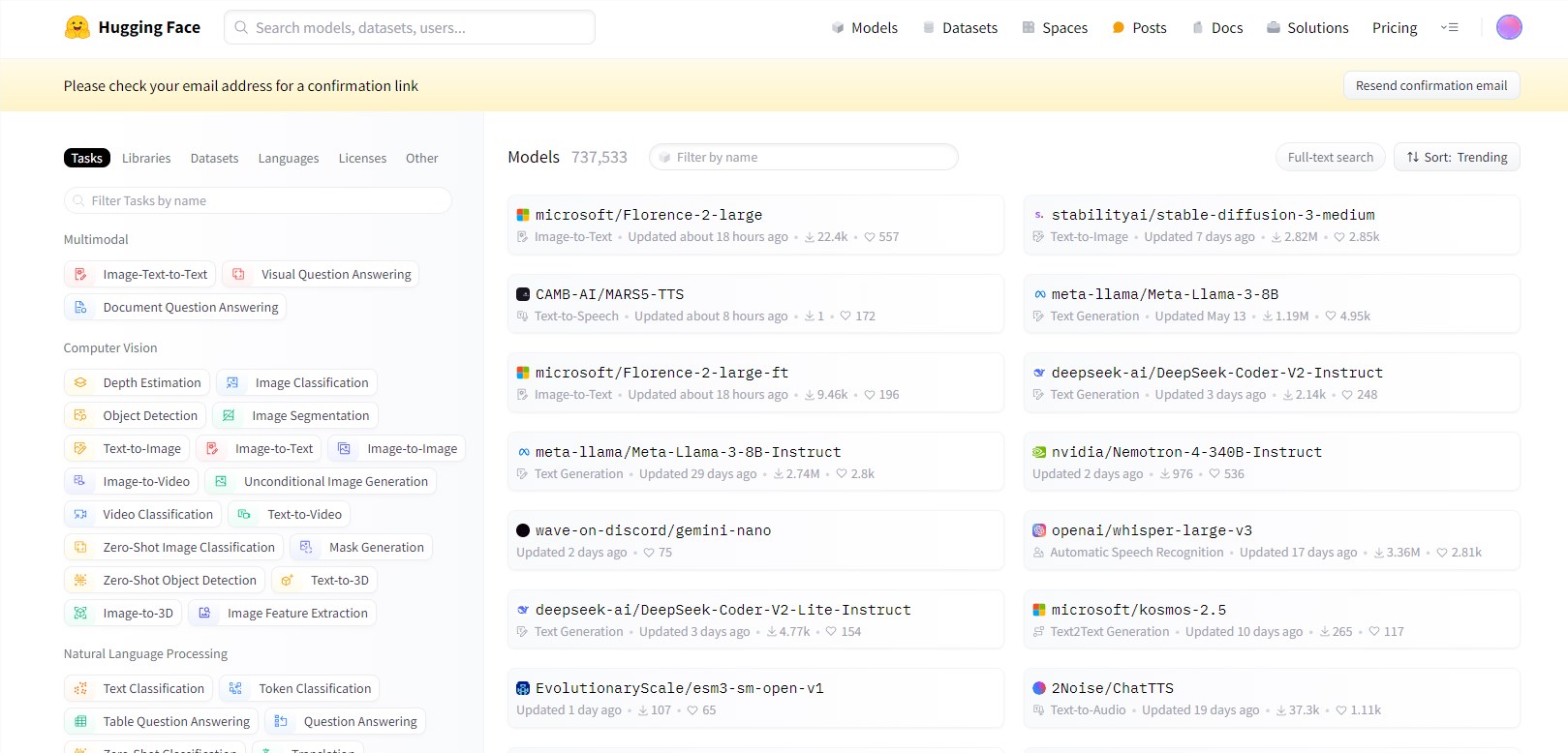

在人工智能领域,性能评估一直是衡量模型进步与发展的重要指标。然而,随着大语言模型(LLMs)的性能提升似乎进入了一个瓶颈期,如何准确、全面地评估模型的实际能力成为了业界关注的焦点。近日,全球知名的开源人工智能社区Hugging Face宣布更新了其Open LLM Leaderboard,这一举措标志着AI评估正式迈入了一个新阶段。

Open LLM Leaderboard作为衡量人工智能语言模型进展的基准工具,自诞生以来便受到了广泛的关注和应用。然而,随着人工智能技术的不断发展,研究人员和公司发现,尽管新模型层出不穷,但突破性改进的速度却逐渐放缓。在这一背景下,Hugging Face决定对Open LLM Leaderboard进行更新,以提供更加严格、细致的评估标准,推动AI技术的持续发展。

据了解,更新后的Open LLM Leaderboard引入了更复杂的评估指标和详细分析,旨在帮助用户更准确地了解哪些测试对特定应用最为相关。这一举措反映了人工智能社区日益增长的认识,即仅凭性能数字本身是不足以评估模型在现实世界中的实用性的。通过引入更全面的评估体系,Hugging Face希望能够更好地识别模型的潜在问题和改进方向,推动AI技术的不断进步。

排行榜的关键变化包括引入更具挑战性的数据集、实施多轮对话评估、扩大非英语语言评估以及加入指令遵循和少样本学习的测试等。这些更新旨在创建一个更全面、更具挑战性的基准集合,以更好地区分表现最佳的模型,并识别改进领域。

首先,更具挑战性的数据集的引入将测试模型在高级推理和现实世界知识应用方面的能力。这意味着模型需要不仅能够回答简单的问题,还需要能够处理更复杂的任务,如推理、理解和应用现实世界的知识。这将有助于评估模型在实际应用中的性能表现,并为模型开发者提供更明确的改进方向。

其次,实施多轮对话评估将更全面地评估模型的会话能力。在以往的评估中,模型往往只被要求回答一次问题或完成一次任务。然而,在实际应用中,模型需要能够与用户进行多轮对话,理解用户的意图和需求,并给出相应的回答或建议。通过实施多轮对话评估,Hugging Face希望更准确地评估模型在实际会话场景中的表现,并推动模型在会话能力方面的提升。

此外,扩大非英语语言评估将更好地代表全球AI能力。随着人工智能技术的不断发展,越来越多的国家和地区开始关注和应用人工智能技术。因此,评估模型在非英语语言下的表现也变得越来越重要。通过扩大非英语语言评估的范围和种类,Hugging Face希望更全面地了解模型在不同语言和文化背景下的性能表现,并推动模型在全球范围内的应用和发展。

最后,加入指令遵循和少样本学习的测试将更好地评估模型在实际应用中的适应性和泛化能力。在实际应用中,模型往往需要面对各种复杂和不确定的情况。通过测试模型在遵循指令和少样本学习方面的能力,Hugging Face希望更准确地评估模型在实际应用中的适应性和泛化能力,并为模型开发者提供更明确的改进方向。

AI旋风认为,Hugging Face更新Open LLM Leaderboard的举措将对开源人工智能开发的格局产生重大影响。通过引入更全面、更严格的评估体系,Hugging Face有望推动AI技术的持续发展,并帮助研究人员和公司更好地了解模型的性能表现和改进方向。同时,这也将促进人工智能技术的广泛应用和普及,为人类社会的发展和进步做出更大的贡献。