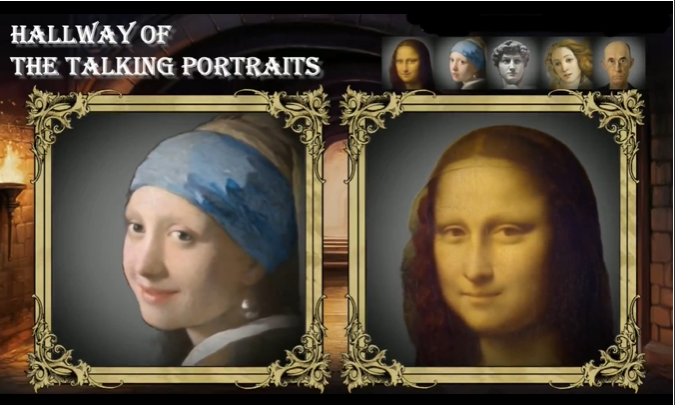

近日,斯坦福大学的研究团队与Apparate Labs携手,带来了一项革命性的技术突破——PROTEUS模型。这一AI模型赋予了静态图片中的虚拟人物以生命,让他们能够实时地唱歌、说话,呈现出逼真的面部表情和身体动作。

PROTEUS模型的核心特点在于其强大的实时生成能力。仅需单张照片,该模型便能生成包括笑、说唱、唱歌、眨眼、微笑、说话等多种效果的逼真虚拟人物。这些虚拟人物不仅面部表情丰富,还能展现出复杂的身体动作,仿佛真实的生命体一般。更令人惊叹的是,这一切都以超过100帧每秒的视频流形式实时呈现,保证了互动的流畅性和自然性。

在技术上,PROTEUS采用了先进的潜在扩散模型和Transformer架构。这种架构使得模型能够在潜在空间中进行高效的数据处理,从而快速生成复杂的图像。通过进一步改进的架构和算法,PROTEUS实现了每秒超过100帧的惊人生成速度,这在同类模型中堪称翘楚。

AI旋风认为,PROTEUS的应用场景极为广泛,几乎可以渗透到生活的方方面面。想象一下,一个个性化的虚拟助理在为你处理日常事务、管理日程、提供信息查询服务;或者一个虚拟宠物,不仅外观逼真,还能展现出丰富的情感,成为你生活中的忠实伙伴;再或者,在教育和培训领域,一个虚拟教师或培训师为你提供个性化的学习指导;在影视和娱乐行业,PROTEUS甚至能生成逼真的虚拟演员和角色,为电影、电视剧等提供全新的制作方式,大幅降低制作成本。

此外,PROTEUS在社交媒体和虚拟社交领域也有着巨大的应用潜力。用户可以在社交平台上生成自己的虚拟形象,与好友进行更加丰富的社交互动。这种全新的社交体验无疑将吸引大量年轻用户的关注。

值得一提的是,PROTEUS的愿景并不仅仅停留在生成逼真虚拟人物这一层面。它更希望提供一个可通过语音控制的视觉化体现,作为人工对话实体的直观接口。这意味着,用户将能够与这些虚拟形象进行自然的对话和互动,仿佛他们真的是活生生的人一样。

为了推动这项技术的广泛应用和发展,研究团队计划将PROTEUS的安全提供和早期API访问权限开放给选定的开发者。这将有助于激发开发者的创造力,进一步拓展PROTEUS在各个领域的应用。

在Twitch直播中,我们已经看到了PROTEUS在实时互动场景中的出色表现。通过API接口,PROTEUS可以轻松集成到任何应用中,为各行业带来前所未有的虚拟人物交互体验。