在人工智能领域,多模态模型的决策能力一直是科研人员关注的焦点。近日,UC伯克利等高校的研究团队成功开发出一种名为RL4VLM的全新强化学习框架,该框架不仅显著提升了多模态大模型在决策任务上的性能,还使得这些模型能够像人类一样看图玩扑克、算“12点”等复杂任务,且其表现已超越GPT-4v。

据了解,这一研究团队由多位业界重量级人物组成,包括图灵奖得主、Meta首席AI科学家、纽约大学教授LeCun,UC伯克利的Sergry Levine教授,以及香港大学数据科学学院院长、UC伯克利教授马毅等。他们的这项突破性研究成果以论文预印本的形式发布,并且相关的代码已在GitHub上开源,供全球科研人员共同学习和研究。

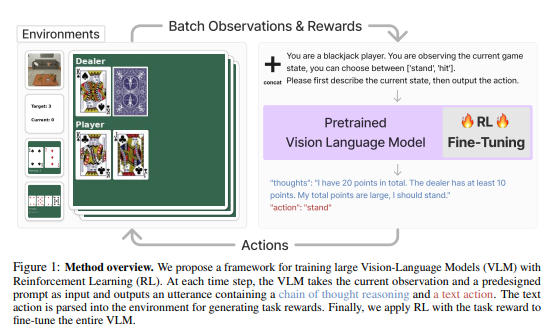

RL4VLM的核心在于其独特的算法框架,它采用强化学习方法对多模态大模型进行微调。与传统的微调方法相比,RL4VLM的奖励信息直接来源于环境,不再依赖于人类反馈。这种自主学习的模式不仅提高了训练效率,还赋予了多模态模型更强的自主决策能力。

为了全面评估RL4VLM的性能,研究团队设计了多个具有挑战性的评测任务。这些任务不仅涵盖了数字识别、逻辑推理等细粒度视觉信息决策能力,还涉及到了具身智能环境中的视觉语义推理能力。具体来说,研究团队设计了数轴(Numberline)、简易12点(EZPoint)、24点(Point24)、21点(Blackjack)和ALFWorld等五个任务。其中,ALFWorld是微软等于2020年提出的开源具身智能任务集,而其他任务则是研究团队的原创设计。

在实验中,RL4VLM展现出了惊人的表现。经过强化学习微调的多模态模型在决策问题上的性能不仅超越了商用模型GPT-4v,还超越了传统的监督微调方法。特别是在ALFWorld的具身智能任务中,RL4VLM模型取得了最高的平均分,尤其在单物体拾取任务上表现突出。这一结果充分证明了RL4VLM在具身智能任务中的强大实力。

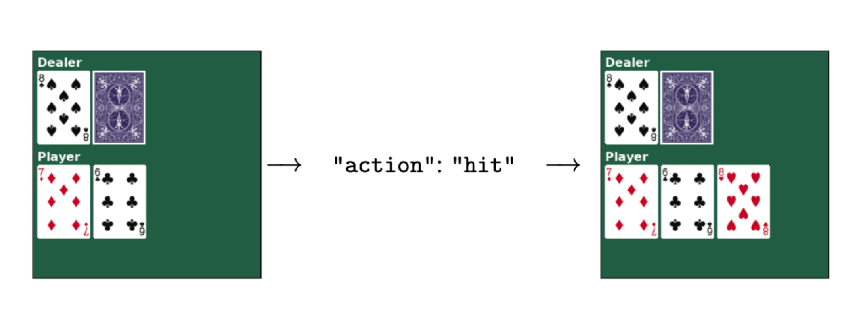

那么,RL4VLM是如何实现这一卓越性能的呢?据了解,其工作流程主要包括以下几个步骤:首先,系统将任务的当前状态以图片和文字描述的形式输入多模态大模型;然后,模型根据输入信息输出一段思维链,并以文字形式输出要执行的动作;接下来,动作信息被输入到环境中并获得相应的奖励值;最后,这些奖励值将用于强化学习训练,以不断优化模型的性能。

为了适应RL训练框架的需求,研究人员对模型的输入和输出进行了精心调整。他们将任务图像和任务描述的文本合并后直接作为当前任务的状态输入给模型;在获得模型的文字输出后,再将其转化为与环境交互的动作指令。这种设计使得模型能够更好地理解任务需求并作出准确的决策。

此外,消融实验的结果也进一步证明了思维链提示过程在任务成功率中的重要性。这一发现为多模态模型的性能提升提供了新的思路和方法。

AI旋风认为,RL4VLM的成功不仅展示了多模态模型在决策任务上的巨大潜力,也为未来人工智能的发展开辟了新的可能性。随着技术的不断进步和应用场景的不断拓展,我们有理由相信多模态模型将在更多领域展现出其独特的优势和价值。