在视频生成技术的领域里,一场革命性的突破正悄然上演。北京大学与快手AI团队携手,成功攻克了复杂视频生成的难题,推出了一款名为VideoTetris的全新视频生成框架。这款框架凭借其卓越的复杂视频生成能力,超越了现有的Pika、Gen-2等商用模型,为视频创作领域注入了新的活力。

VideoTetris框架以其独特的“拼图”理念,将视频生成过程变得像组合拼图一样简单而高效。它能够轻松组合各种细节,生成高难度、指令复杂的视频。这种创新的方式不仅打破了传统视频生成的局限,还为创作者们提供了更加广阔的创作空间。

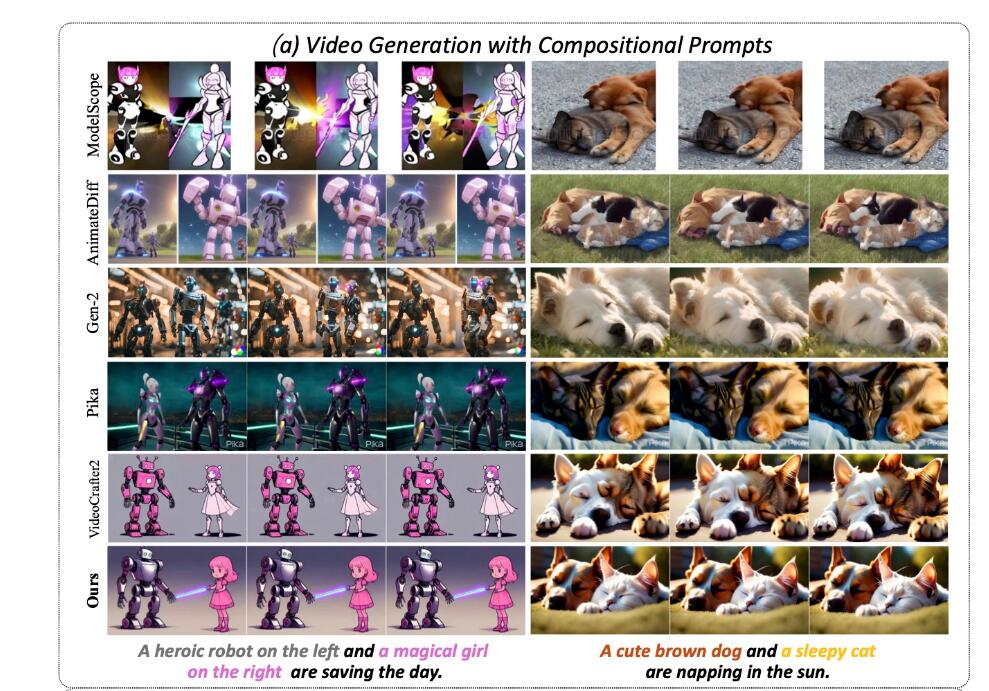

在VideoTetris框架中,研究人员首次定义了组合视频生成任务,包括两个核心子任务:一是跟随复杂组合指令的视频生成,二是跟随递进的组合式多物体指令的长视频生成。通过深入研究和实践,团队发现现有的开源模型和商用模型在应对这些任务时存在明显的不足。例如,在输入指令“左边一个可爱的棕色狗狗,右边一只打盹的猫在阳光下小憩”时,这些AI模型往往无法正确生成符合指令的视频,结果显得怪异且不符合预期。

然而,VideoTetris框架却能够成功保留所有的位置信息和细节特征,准确地将指令转化为生动的视频画面。在长视频生成方面,它更是支持更复杂的指令,如“从一只可爱的棕色松鼠在一堆榛子上过渡到一只可爱的棕色松鼠和一只可爱的白色松鼠在一堆榛子上”。在VideoTetris的神奇作用下,生成的视频不仅顺序与输入指令一致,而且两只松鼠还能自然地交换食物,展现出生动有趣的场景。

VideoTetris框架之所以能够实现如此出色的性能,关键在于其采用了时空组合扩散方法。这种方法首先将文本提示按时间解构,为不同视频帧指定不同的提示信息。然后,在每一帧上进行空间维度的解构,将不同物体对应到不同的视频区域。最后,通过时空交叉注意力进行组合,实现高效的组合指令生成。这种创新的方法使得VideoTetris在复杂视频生成任务中表现出色,超越了现有的商用模型。

为了进一步提升长视频生成的质量,团队还提出了一种增强的训练数据预处理方法。这种方法使得长视频生成更加动态稳定,减少了偏色现象的发生。此外,他们还引入了参考帧注意力机制,使用原生VAE对之前的帧信息编码。这种编码方式相比于其他模型使用的CLIP编码方式,能够更好地保持内容的一致性,使得生成的视频更加自然流畅。

为了评估VideoTetris框架的性能,团队还引入了新的评测指标VBLIP-VQA和VUnidet。这些指标首次将组合生成评价方法扩展到视频维度,为复杂视频生成任务提供了更加全面准确的评价手段。实验测试表明,在组合视频生成能力上,VideoTetris模型的表现超过了所有开源模型,甚至是商用模型如Gen-2和Pika。

AI旋风认为,VideoTetris框架的推出无疑将为视频生成领域带来深远的影响。它不仅能够提升视频生成的质量和效率,还将激发更多的创作者们发挥创意和想象力,创作出更加精彩纷呈的视频作品。此外,VideoTetris框架的开源也将为学术界和工业界的研究人员提供更多的参考和借鉴,推动整个视频生成领域的发展。