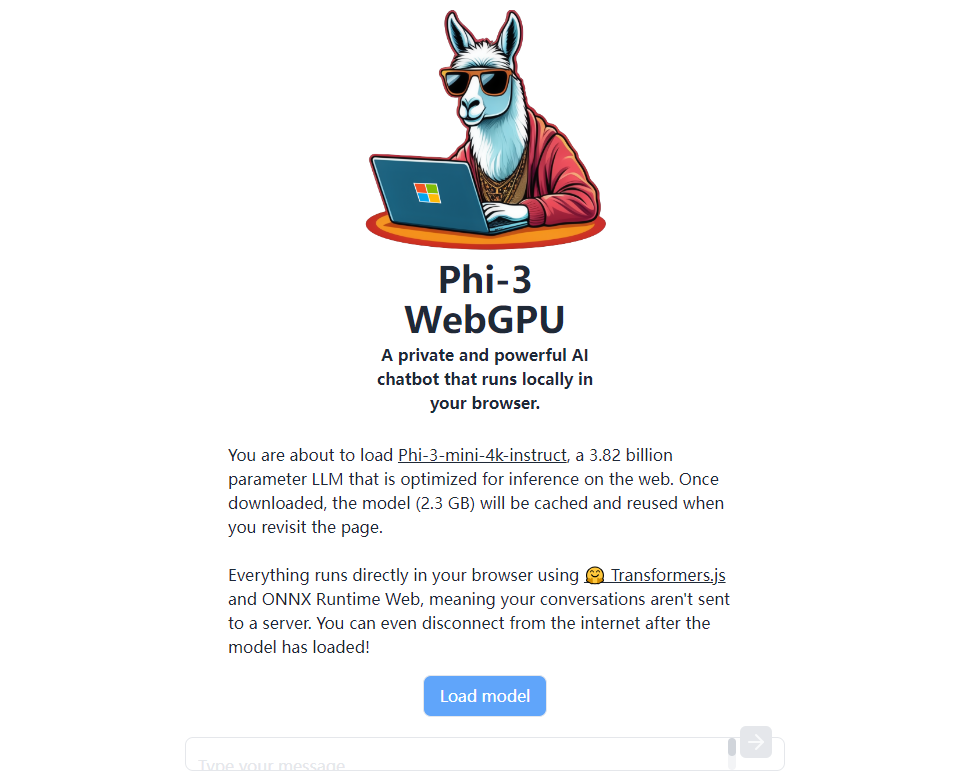

近日,Xenova公司在Hugging Face Space上发布了一款名为Phi-3 WebGPU的AI模型,这一创新工具打破了传统AI模型运行模式的局限,允许用户直接在浏览器中本地运行Phi-3模型,为用户带来了私密且高效的AI体验。

Phi-3 WebGPU的推出,标志着AI技术在浏览器端应用的一次重要突破。它结合了Transformers.js和onnxruntime-web两大技术,将AI模型运行的权限下放至用户本地,从而大幅提升了数据处理的私密性和效率。

“AI旋风认为,Phi-3 WebGPU的推出不仅是对AI技术的一次革新,更是对用户体验的一次提升。”这款工具的主要特点体现在以下几个方面:

一、本地数据处理确保隐私安全

在Phi-3 WebGPU中,所有的数据处理都在本地完成,无需上传至云端服务器。这一设计极大地保障了用户数据的隐私安全,让用户无需担心个人信息的泄露。同时,本地处理也避免了网络延迟和带宽限制对AI模型运行效率的影响,使得模型运行更加流畅和迅速。

二、WebGPU加速提升处理速度

Phi-3 WebGPU利用WebGPU加速技术,使得模型处理速度得到了显著提升。根据官方数据,其处理速度能够超过20t/s,远超传统云端AI模型的处理速度。这意味着用户可以更快地得到AI模型的输出结果,从而提高了工作效率和体验。

三、模型缓存避免重复下载

在首次运行Phi-3 WebGPU时,系统会自动下载2.3GB的模型文件。然而,一旦模型文件被下载并存储至本地,用户再次使用时将无需重复下载,从而节省了时间和带宽资源。这一设计不仅提高了用户体验,也降低了用户的使用成本。

四、英文回答效果令人满意,中文回答存在改进空间

在使用Phi-3 WebGPU时,用户发现其英文回答效果令人满意。然而,在中文回答方面,该模型存在一些幻觉现象,即输出的结果与用户期望的答案存在偏差。这可能与模型的训练数据或算法有关,未来Xenova团队有望通过优化算法和增加训练数据来提高中文回答的准确性和可靠性。

尽管Phi-3 WebGPU在某些语言的处理上可能存在不足,但其在浏览器中提供的AI模型运行能力仍然值得关注。这一创新工具不仅提高了用户的工作效率,还通过本地运行确保了数据处理的私密性。未来,随着技术的不断进步和优化,Phi-3 WebGPU有望在更多领域得到应用和推广。

“AI旋风相信,Phi-3 WebGPU的推出将为用户带来更加便捷、高效和私密的AI体验。”同时,这也将激发更多开发者和研究者探索AI技术在浏览器端的应用和创新,推动AI技术的不断发展和进步。