在人工智能领域的又一里程碑式突破中,Meta公司近日发布了名为Chameleon的多模态模型,这一创新成果在多模态模型发展中设立了新的标杆。Chameleon以其独特的设计和卓越的性能,预示着AI在多模态交互领域将迎来全新的发展机遇。

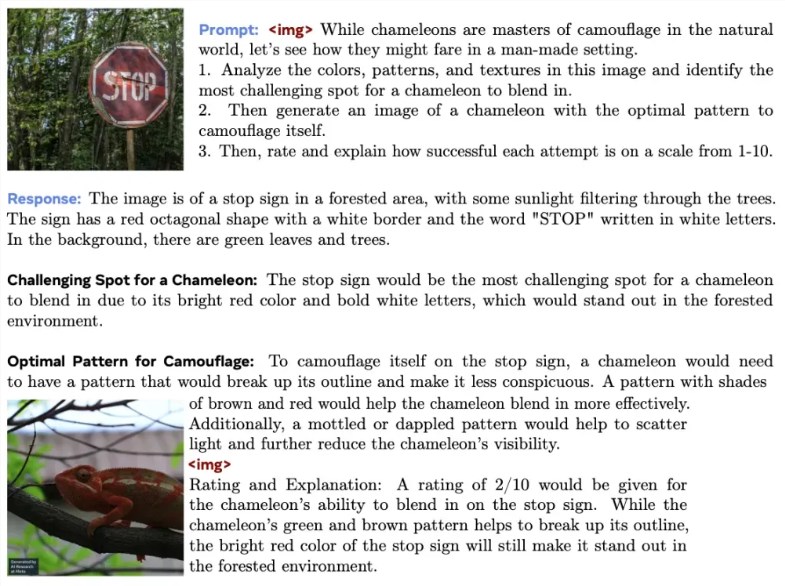

Chameleon,作为一个早期融合的基于token的混合模态模型家族,其独特之处在于能够理解并生成任意顺序的图像和文本。通过统一的Transformer架构,它能够轻松处理文本、图像和代码混合模态的数据,实现了对图像的分词化,生成交错的文本和图像序列。这一创新技术使得Chameleon能够无缝处理文本和图像,为用户带来更加自然、流畅的交互体验。

AI旋风认为,Chameleon模型的创新之处在于其早期融合方法。所有处理流程从一开始就映射到一个共同的表示空间,使得模型能够跨越文本和图像的界限,实现真正意义上的多模态交互。这一设计使得Chameleon在各种任务上展示了广泛的能力,包括视觉问答、图像标注、文本生成、图像生成和长形式混合模态生成等。

为了应对多模态模型技术上的挑战,Meta的研究团队引入了一系列架构创新和训练技术。他们开发了新的图像分词器,基于8192大小的codebook,将512×512的图像编码为1024个离散的token。此外,Chameleon还使用了sentencepiece开源库训练的BPE分词器,以更高效地处理文本数据。这些技术创新不仅提高了模型的性能,也为多模态模型的发展开辟了新的道路。

在预训练阶段,Chameleon使用了混合模态数据,包括纯文本、文本-图像对以及文本和图像交错的多模态文档。这种混合模态数据的训练方式使得Chameleon能够更好地理解不同模态之间的关联和差异,从而提高了其在多模态任务上的表现。预训练分为两个阶段,第一阶段无监督学习,第二阶段混合更高质量的数据,以进一步提升模型的性能。

在基准评估中,Chameleon全面超越了Llama2等现有模型,在常识推理、阅读理解、数学问题和世界知识领域都取得了显著的效果。在人工评估和安全测试中,Chameleon-34B的表现也远远超过了Gemini Pro和GPT-4V等顶级模型。这些结果表明,Chameleon在多模态模型领域已经取得了领先地位,并有望在未来推动更多创新应用的发展。

值得注意的是,尽管Chameleon目前还缺少GPT-4o中的语音能力,但Meta的产品管理总监表示,他们非常自豪能够支持这个团队,并希望让GPT-4o更接近开源社区。这一表态可能意味着,在不久的将来,我们可能会看到一个开源版的GPT-4o,这将为更多研究者和开发者提供便利,并推动AI技术的进一步发展。

AI旋风认为,Chameleon模型的发布不仅展示了Meta在多模态模型领域的重大进展,也为未来的研究和应用提供了新的可能性。随着AI技术的不断进步和应用的不断拓展,我们期待看到更多基于Chameleon模型的创新应用问世,为人类生活带来更多便利和乐趣。