近日,科技界迎来了一项引人注目的创新——来自伦敦帝国理工学院和戴尔公司的联合研究团队成功推出了StyleMamba,这是一种革命性的AI模型,旨在通过文本驱动的方式高效实现图像风格转换,同时保持原始图像内容的完整性。StyleMamba的推出,标志着文本驱动风格化技术迈入了新的里程碑,其高效的计算性能和优化的风格化过程,为图像创作和编辑领域带来了无限可能。

在传统的文本驱动风格化技术中,往往需要庞大的计算资源和冗长的训练过程,这不仅限制了技术的广泛应用,也增加了成本和时间投入。然而,StyleMamba通过引入一种全新的条件空间模型,彻底改变了这一局面。这一模型专为高效的文本驱动图像风格转移而设计,通过顺序地将图像特征与目标文本提示进行对齐,实现了对风格化的精确控制。

据AI旋风了解,StyleMamba的独特之处在于其引入的两种创新损失函数——二阶方向损失和掩码损失。这两种损失函数在确保图像与书面提示之间的局部和全局风格一致性方面发挥了关键作用。通过优化这些损失函数,StyleMamba将所需的训练迭代次数减少了5倍,推理时间减少了3倍,从而显著提升了风格化的效率和效果。

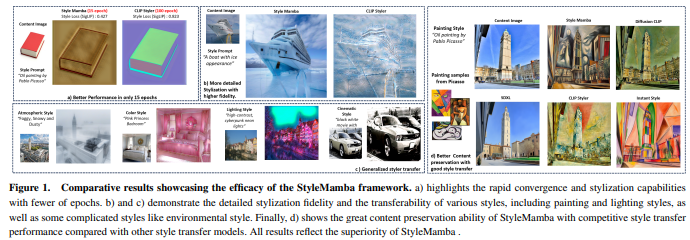

为了验证StyleMamba的有效性,研究团队进行了大量测试和定性分析。结果显示,StyleMamba在风格化质量和速度方面均表现出色,明显优于当前基线方法的性能。这一框架不仅提供了一种更有效、更经济的方式将口头描述转换为视觉上吸引人的风格,而且能够保持原始图像材料的完整性和精神。

研究团队在总结StyleMamba的主要贡献时强调,该模型通过将条件Mamba整合到AutoEncoder架构中,构建了一个简单而强大的框架。这种整合使得文本驱动的风格转移过程更加快速和高效,简化了与当前方法的比较。此外,StyleMamba利用损失函数来提高风格化质量,确保全局和局部风格的一致性,同时不损害图像的原始内容,进一步加快了风格化过程。

AI旋风认为,StyleMamba的推出不仅为图像创作和编辑领域带来了革命性的变化,也为AI技术在艺术和设计领域的应用开辟了新的道路。该模型的多功能性和适应性使其在各种应用和媒体格式上均表现出色,包括多种风格转移任务和视频风格转移。随着StyleMamba的进一步发展和优化,我们有理由相信,它将为未来的图像创作和编辑领域带来更多的创新和突破。