网络安全领域近日迎来了一则令人瞩目的消息。据Sysdig威胁研究团队披露,研究人员发现了一种名为“LLMjacking”的新颖攻击方式,这种攻击专门针对云托管的大型语言模型(LLM)服务,旨在窃取云凭证,进而向其他威胁行为者出售对LLM服务的访问权限。

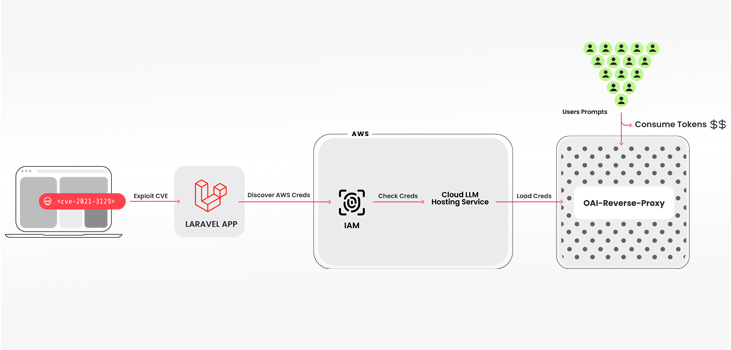

据研究人员Alessandro Brucato介绍,LLMjacking攻击的核心在于利用窃取的云凭证进入云环境,进而访问云提供商托管的本地LLM模型。在此次发现的案例中,攻击者的目标主要是Anthropic的本地Claude(v2/v3)LLM模型。攻击者通过利用易受攻击版本的Laravel框架(如CVE-2021-3129)的漏洞,成功获取了亚马逊云服务(AWS)凭证,进而获得了对LLM服务的访问权限。

在攻击过程中,攻击者使用了多种工具和技术。首先,他们利用一个开源的Python脚本来检查和验证Anthropic、AWS Bedrock、Google Cloud Vertex AI、Mistral和OpenAI等产品的密钥。值得注意的是,在验证阶段,攻击者并没有真正运行任何合法的LLM查询,而是仅仅进行了足够的工作来确定凭证的功能和任何配额限制。这种谨慎的操作方式表明攻击者具有高度的专业性和针对性。

此外,研究人员还发现攻击者使用了另一个名为oai-re-proxy的开源工具,该工具充当LLM API的反向代理服务器。这种设置表明攻击者很可能正在提供对被攻陷帐户的访问权限,而不直接暴露底层凭证。这种操作方式不仅增加了攻击者的隐蔽性,还使得他们能够轻松地将非法获取的访问权限进行货币化。

在攻击过程中,攻击者还查询了日志设置,很可能是为了规避检测。他们通过精心设计的操作来避免在使用被攻陷的凭证运行其提示时被云提供商或安全团队发现。这种发展与传统的注重提示注入和模型污染的攻击方式有所不同,而是允许攻击者在云账户的所有者不知情或未经同意的情况下利用他们对LLMs的访问权限进行非法活动。

Sysdig警告称,这种攻击可能导致受害者每天产生超过46,000美元的LLM消耗成本。Brucato指出:“使用LLM服务可能非常昂贵,具体取决于所使用的模型和被输入的令牌数量。攻击者通过最大化配额限制,不仅可以从中获利,还可以阻止受损组织合法使用模型,从而干扰其正常运营。”

面对这一严峻的安全威胁,AI旋风建议组织采取一系列措施来加强防护。首先,启用详细日志记录并监视云日志以发现可疑或未经授权的活动是至关重要的。此外,建立有效的漏洞管理流程以防止初始访问是防止此类攻击的关键。组织应定期更新系统和应用程序补丁,以修复已知漏洞,并限制对敏感数据和资源的访问权限。

总之,LLMjacking攻击的出现再次提醒我们,网络安全领域需要持续关注新兴威胁和技术发展。随着AI技术的广泛应用和云服务的普及,保护云托管AI模型的安全将变得越来越重要。