近日,芝加哥大学的研究人员开发出了一款名为Nightshade的创新工具,旨在防止AI图像生成器在未经许可的情况下使用图像进行训练,从而保护艺术家和版权所有者的作品权益。

据了解,Nightshade工具通过在图像中添加一种特殊的隐藏信息来发挥其作用。这些信息对于人眼来说是不可见的,但对于AI图像生成器来说却是致命的。当AI图像生成器,如目前流行的Stable Diffusion,尝试使用这些带有隐藏信息的图像进行训练时,这些额外的信息会干扰生成器的正常工作,导致输出的图像失真,从而无法有效地用作训练数据。

值得一提的是,Nightshade工具的这种干扰效果具有极高的鲁棒性。即使对被“毒害”的图像进行裁剪、编辑和压缩等操作,其中的隐藏信息依然能够保持有效。更令人惊奇的是,即便是对被“毒害”的图像进行截屏或在显示器上显示,这些隐藏信息依然能够发挥作用。任何由此产生的图像如果被AI模型处理,都会产生失真,从而确保了艺术家和版权所有者的作品不会被滥用。

与其他相关工具相比,Nightshade具有其独特之处。与Stability AI提供的选择退出机制相比,Nightshade更注重从源头上遏制未经许可的图像使用,通过增加使用未经许可内容的图像生成器开发者的成本,来达到保护作品的目的。而与Glaze这类旨在阻止AI模型复制艺术家独特风格的工具相比,Nightshade则更加直接地针对了AI图像生成器的训练过程,从源头上防止了未经许可的图像被用于训练。

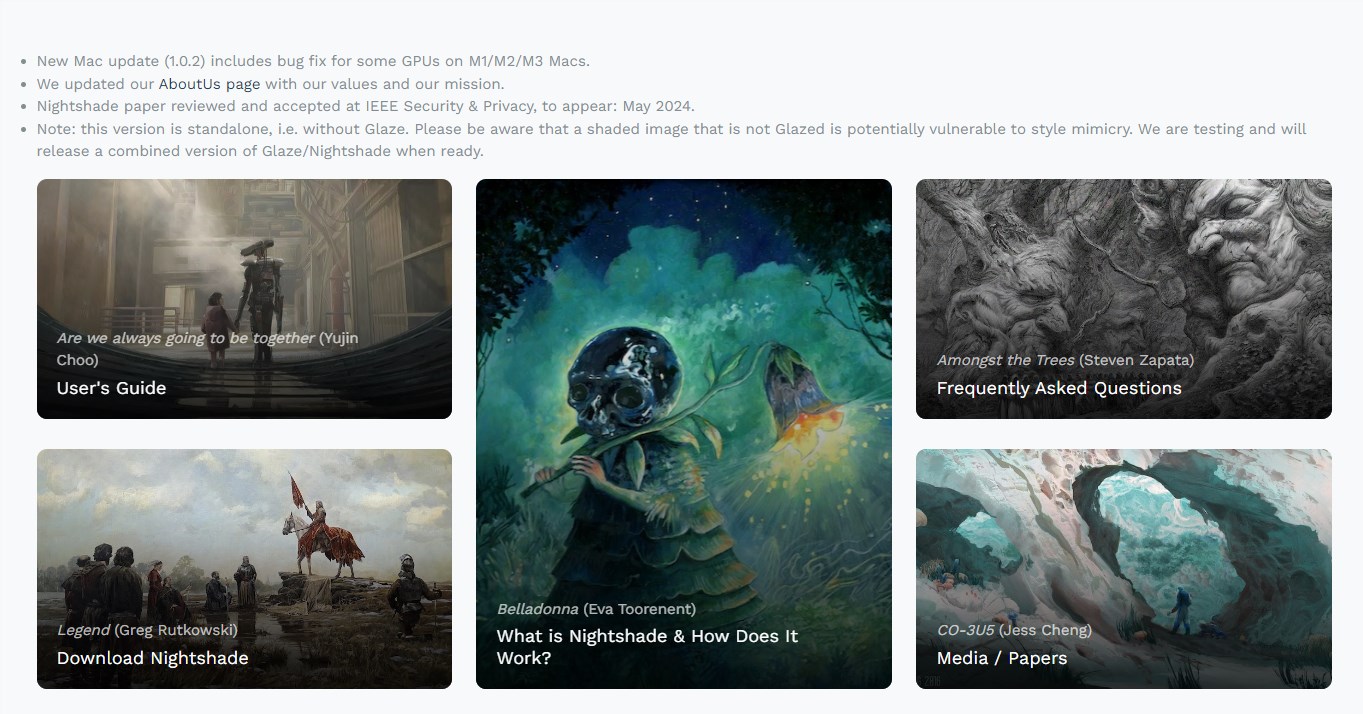

值得一提的是,Nightshade工具对任何人都是可用的。用户可以从该项目的网站上轻松下载,并且可以在Windows和Mac等操作系统上运行。更令人欣喜的是,运行Nightshade并不需要任何额外的GPU驱动程序,这使得更多的用户能够方便地使用这一工具来保护自己的作品。

AI旋风认为,Nightshade工具的推出是AI技术发展的又一重要里程碑。它不仅仅为艺术家和版权所有者提供了更为有效的保护手段,也促使AI图像生成器在使用时更加注重对版权的尊重。随着越来越多的工具加入到保护艺术家作品的行列中,如麻省理工学院的PhotoGuard等,相信未来AI技术的发展将更加健康、有序。

然而,我们也应看到,尽管这些工具在一定程度上保护了艺术家的权益,但AI技术的发展仍面临着诸多挑战和争议。如何在保护版权的同时,促进AI技术的创新和应用,将是未来我们需要深入思考和探讨的问题。

总之,Nightshade工具的推出为艺术家和版权所有者提供了更为强大的保护手段,也为AI技术的发展注入了新的活力。我们期待未来能够看到更多类似的工具和措施出现,共同推动AI技术的健康发展。