近日,科技巨头微软在AI领域遭遇了一场不小的风波。在Meta公司发布了备受瞩目的超级大语言模型Llama 3之后,微软不甘示弱,迅速推出了自家新一代的大语言模型WizardLM2 8x22B,宣称其性能强大,超越Claude 3 Opus、Sonnet以及GPT-4等竞品,并且开源共享。然而,就在外界翘首以待其大放异彩之时,微软却做出了一个令人大跌眼镜的决定——紧急撤回了这款刚刚发布的大模型。

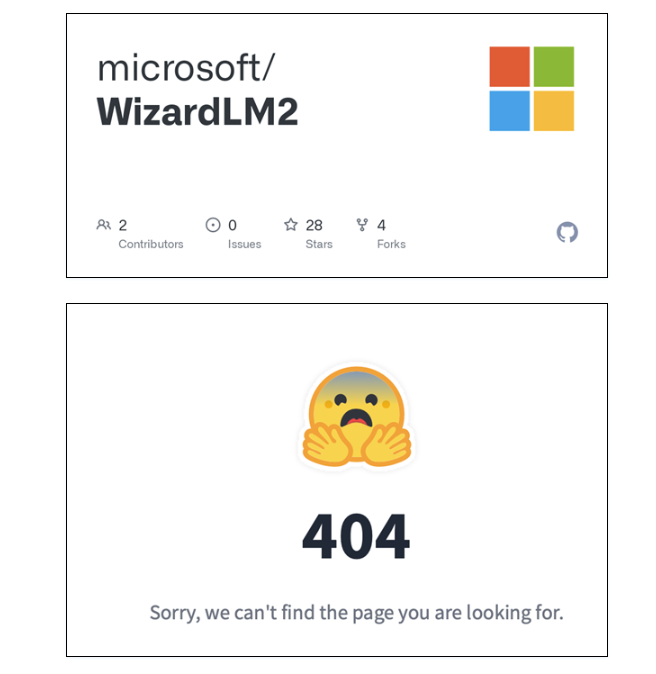

这一突发事件毫无征兆,微软在没有任何预告的情况下,突然删除了WizardLM2大模型的相关文件和代码,并一直未对外公开解释此举的原因。外界对此猜测纷纷,好奇这款被誉为最先进的大模型究竟遭遇了什么问题。

直到微软内部的一位工程师透露了真相,才让人不禁啼笑皆非。原来,微软在推出WizardLM2大模型的过程中,居然遗漏了关键的幻觉测试(toxicity test)。据悉,微软已经有一段时间没有发布新的大模型,对新流程的生疏导致了这一低级失误的发生。目前,微软正在紧急补测这一必要的环节,并计划尽快重新上线WizardLM2大模型。

“大语言模型的幻觉”是一个值得深入探讨的问题。它主要分为两种类型:事实性幻觉和忠实性幻觉。事实性幻觉指的是模型生成的内容与可验证的现实世界事实存在不一致性,而忠实性幻觉则是指模型生成的内容无法满足用户的指令或上下文要求。这两种幻觉的存在,都严重影响了大语言模型的准确性和可靠性。

而造成大语言模型幻觉的原因多种多样,训练数据、预训练阶段、对齐阶段以及推理阶段都可能出现缺陷。微软此次忘记进行幻觉测试,无疑暴露出在大模型开发和上线流程中的疏忽和不严谨。

AI旋风认为,此次事件不仅给微软敲响了警钟,也为整个AI行业敲响了警钟。大语言模型作为AI技术的重要组成部分,其准确性和可靠性至关重要。任何一丝的疏忽和马虎,都可能导致严重后果。微软此次的失误,虽然看似偶然,但也反映出在AI技术快速发展的同时,相关的质量控制和测试环节却未能跟上步伐。

此外,也有观点认为,微软此次紧急撤回大模型,并非仅仅是因为忘记了测试。有人认为这可能是微软为保护技术机密而采取的临时措施,毕竟一个先进的大语言模型蕴含着巨大的商业价值和潜在的市场竞争力。不过,无论是何种原因,微软都需要对此次事件进行深刻的反思和改进。

值得一提的是,大语言模型的技术缺陷并非个案。虽然基于大模型的AI技术带来了许多创新和突破,但同时也面临着诸多技术挑战和限制。例如,模型复杂度和参数数量巨大,导致训练时间和成本极高;数据量庞大且不均衡,容易影响模型的准确性;大模型的解释能力弱,使得决策结果难以被理解;以及特征选择和模型调优容易受到专家知识的影响等。

综上所述,微软此次紧急撤回WizardLM2大模型的事件,虽然令人啼笑皆非,但也提醒我们在追求技术进步的同时,不能忽视质量控制和测试环节的重要性。只有确保技术的准确性和可靠性,才能更好地推动AI技术的发展和应用。