3月7日,全球知名芯片制造商AMD公司发布了一项令人振奋的公告,宣布用户现在可以在其最新的硬件平台上本地化运行基于GPT的大语言模型(LLM),从而构建出专属于自己的AI聊天机器人。这一技术的推出,无疑将进一步推动人工智能技术在个人和企业用户中的普及和应用。

据AI旋风了解到,AMD明确表示,用户可以在采用AMD新XDNA NPU的Ryzen 7000和Ryzen 8000系列APU,以及内置AI加速核心的Radeon RX 7000系列GPU设备上,顺利实现LLM和AI聊天机器人的本地运行。这一技术革新,不仅拓宽了AMD硬件产品的应用范围,也为用户提供了更加灵活和高效的AI解决方案。

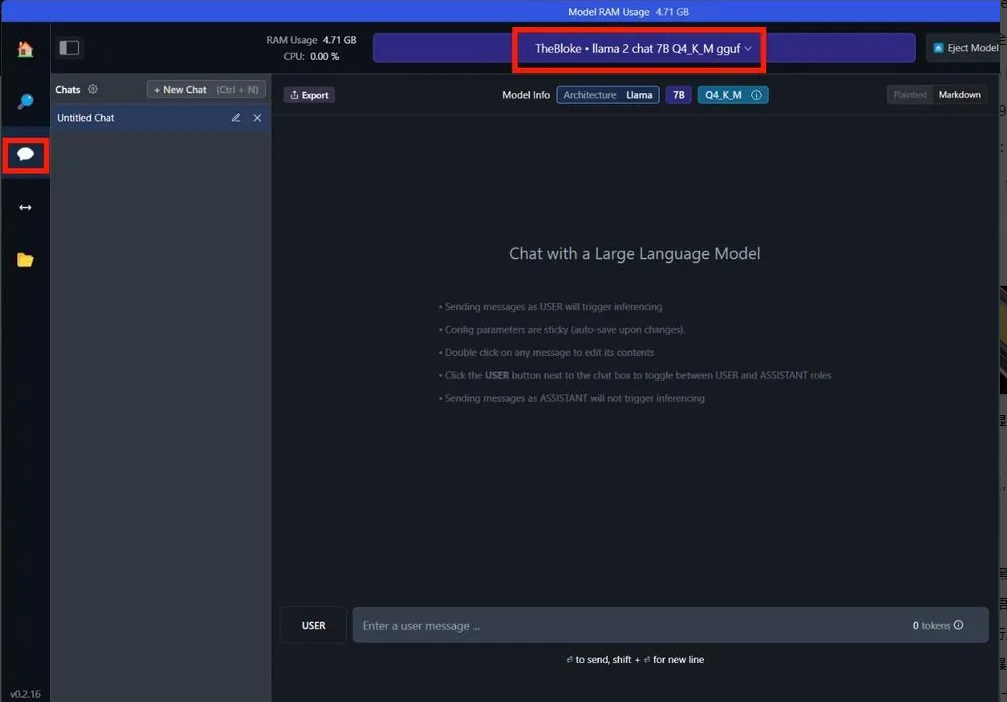

在公告中,AMD还为用户提供了详细的运行步骤。例如,如果用户希望运行70亿参数的Mistral模型,只需在相应的资源库中搜索并下载“TheBloke / OpenHermes-2.5-Mistral-7B-GGUF”即可。而对于70亿参数的LLAMA v2模型,用户同样可以方便地通过搜索“TheBloke / Llama-2-7B-Chat-GGUF”进行下载。这些详细的操作指南,使得即便是非专业用户也能够轻松上手,享受到AI聊天机器人带来的便捷与乐趣。

AMD此举并非业内首创,但无疑为这一领域注入了新的活力。此前,英伟达(NVIDIA)已推出了“Chat with RTX”功能,该功能基于GeForce RTX 40和RTX 30系列GPU,通过TensorRT-LLM功能集进行加速,为用户提供本地化数据集上的快速生成的人工智能结果。然而,AMD的加入使得这一市场竞争更加激烈,同时也为用户提供了更多样化的选择。

AI旋风认为,AMD开放GPT大语言模型本地化运行,不仅展示了其在人工智能领域的深厚实力,也体现了其对于市场需求的敏锐洞察。随着人工智能技术的不断发展,越来越多的用户开始关注如何将这些先进的技术应用到日常生活和工作中。AMD的这一举措,正好满足了用户的这一需求,为AI技术的普及和应用提供了强有力的支持。

同时,这也标志着AMD在硬件与软件融合方面迈出了重要的一步。通过将先进的硬件平台与强大的AI算法相结合,AMD为用户提供了一个更加完整和高效的解决方案。这不仅有助于提升用户的使用体验,也将进一步推动AMD在人工智能领域的领先地位。

然而,尽管AMD的这项技术带来了诸多便利,但我们也需要看到其中的挑战和机遇。随着AI技术的深入应用,如何确保数据的安全性和隐私性将成为一个重要的问题。此外,随着更多公司的加入,市场竞争也将愈发激烈。因此,AMD需要不断创新和完善其产品和技术,以应对市场的变化和用户的需求。

总的来说,AMD开放GPT大语言模型本地化运行是一项具有里程碑意义的技术革新。它为用户提供了更加灵活和高效的AI解决方案,同时也推动了人工智能技术的普及和应用。我们期待看到AMD在未来能够继续为用户带来更多创新和惊喜。