近日,微软研究团队发布了一款名为LLMLingua-2的创新模型,该模型在任务不可知的情境下实现了高效的提示压缩功能。通过智能地剔除长提示中不必要的词语或标记,同时确保关键信息的完整保留,LLMLingua-2成功将提示长度缩减至原长度的20%,从而显著降低了成本并减少了处理延迟。微软研究团队在描述这一成果时指出:“自然语言本身就存在冗余,不同部分所承载的信息量并非均等。”

在性能表现上,LLMLingua-2展现出了惊人的优势。相比其前身LLMLingua以及其他类似方法,新模型的处理速度提升了3到6倍。这一显著提升得益于LLMLingua-2采用的先进算法和高效的数据处理方式。该模型利用MeetingBank中的丰富示例进行训练,该数据集包含大量会议记录及其摘要,为模型提供了充足的语料资源。

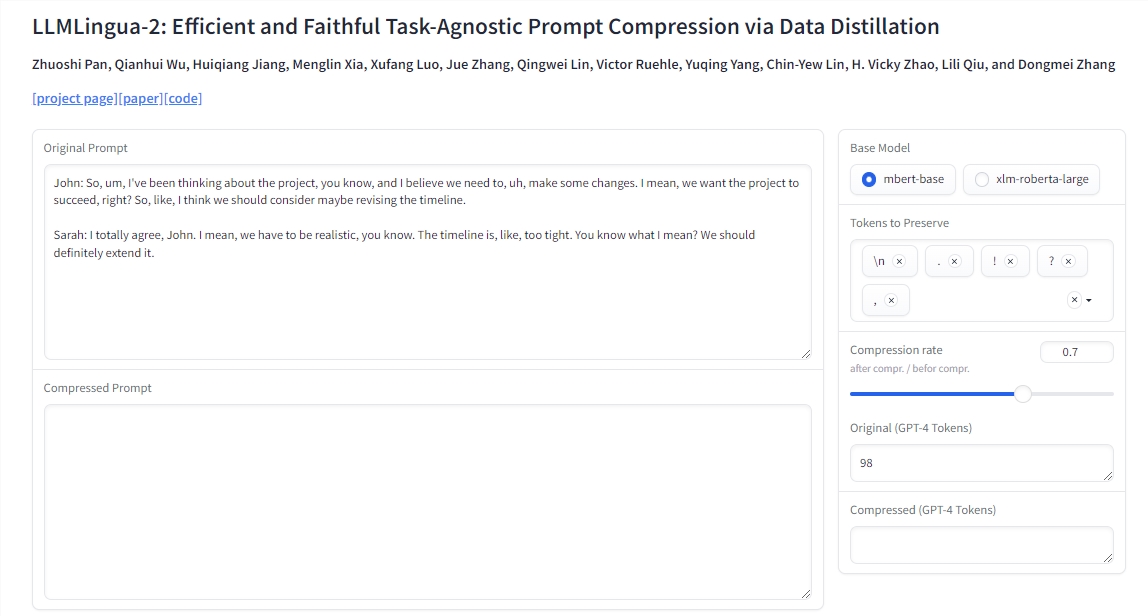

在实际应用中,LLMLingua-2的压缩过程十分便捷。用户只需将原始文本输入训练好的模型中,模型便会自动对每个词语进行评分,并根据其在上下文中的重要性分配保留或移除的点数。随后,模型会选择具有最高保留值的词语,从而创建出精简而有效的缩短提示。

为了验证LLMLingua-2的实用性和性能,微软研究团队在多个数据集上进行了严格的评估,包括MeetingBank、LongBench、ZeroScrolls、GSM8K和BBH等。尽管LLMLingua-2的模型规模相对较小,但在各种语言任务中,如问答、摘要和逻辑推理等,它均表现出了优于原始LLMLingua和选择性上下文策略的性能。此外,该压缩策略对不同的大型语言模型(LLM)和多种语言同样有效,无论是从GPT-3.5到Mistral-7B的大型语言模型,还是从英语到中文等多种语言,都能实现有效的提示压缩。

值得一提的是,LLMLingua-2的集成与应用过程也异常简便。该模型仅需两行代码即可轻松实现集成,并已成功整合到广受欢迎的RAG框架LangChain和LlamaIndex中。为了方便用户更好地理解和应用这一技术,微软还提供了详细的演示、实际应用示例以及解释提示压缩好处和成本节省的脚本。

AI旋风认为,LLMLingua-2的推出不仅体现了微软在人工智能领域的深厚积累与创新实力,更标志着自然语言处理技术在效率提升和成本优化方面迈出了坚实的一步。通过压缩AI提示,LLMLingua-2不仅有助于减少计算和存储资源的使用,还能加速模型的响应速度,提升用户体验。同时,这一技术也有望推动AI在更多领域的应用落地,为未来的智能化社会奠定坚实基础。

展望未来,我们期待LLMLingua-2能够在更多实际场景中发挥作用,助力企业提升工作效率、降低成本,并为人工智能技术的持续创新和发展注入新的活力。同时,我们也希望微软能够继续深耕人工智能领域,推出更多具有创新性和实用性的技术成果,为人类社会的进步贡献更多力量。