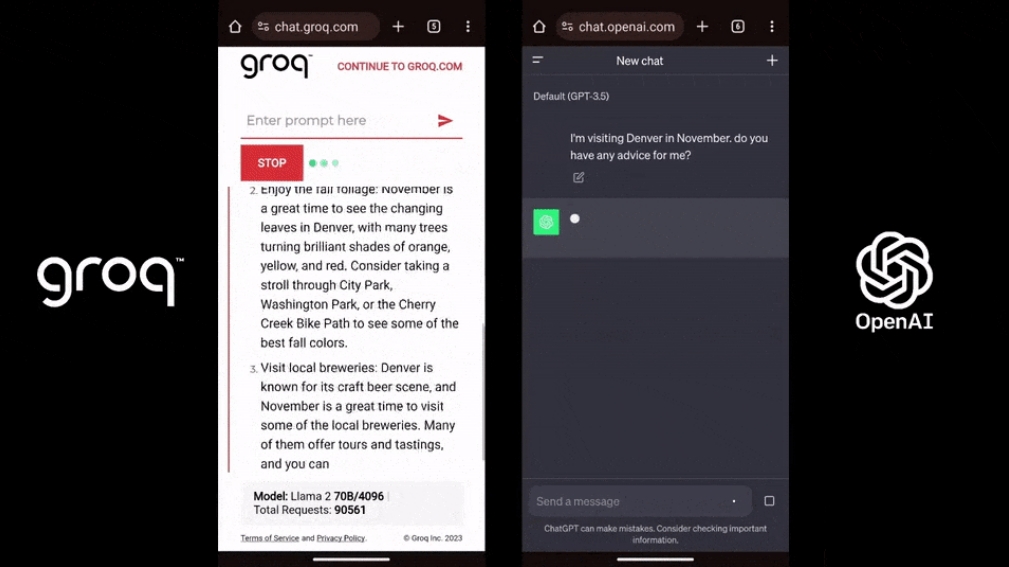

近日,一股新的技术浪潮在全球互联网领域掀起波澜。每秒能够生成500个令牌的Groq模型以其惊人的速度,被誉为“全球速度之最的LLM”,迅速席卷全网。其卓越性能引发了网友们的热烈讨论,纷纷将其与GPT-4和Gemini模型进行对比测试。

在一项基础代码调试任务的测试中,Groq模型展现出了令人震惊的速度优势。相较于Gemini模型,Groq模型的输出速度快了整整十倍;而与GPT-4相比,其速度更是提升了惊人的十八倍。这一结果无疑证明了Groq模型在处理大规模语言模型任务时的卓越性能。

值得一提的是,Groq平台不仅提供了这一高性能模型,还为用户提供了直接试用这些模型的机会。目前,平台上可供选择的有两种先进的模型:Mixtral8x7B-32k和Llama 270B-4k。用户无需任何门槛,即可体验这些强大模型所带来的高效处理能力,无论是进行代码生成、文本理解还是其他自然语言处理任务,都能轻松应对。

Groq模型的崛起背后,其自主研发的语言处理单元(LPU)发挥了至关重要的作用。在处理LLM任务时,Groq LPU展现出了卓越的性能,相较于传统的GPU,其速度提升了高达10倍。这一优势在最近的一系列基准测试中得到了充分验证。搭载于Groq LPU推理平台上的Llama 2 70B模型刷新了各项记录,其推理性能远超市场上的顶级云服务提供商,彰显了Groq LPU在大规模语言模型处理领域的压倒性优势。

与传统GPU专为图形渲染设计不同,Groq的LPU特别针对AI计算需求进行了优化。它具备大量并行处理核心,能够实现高性能表现。此外,LPU采用了时序指令集计算机(Temporal Instruction Set Computer)原理,与传统GPU的工作方式有本质区别。这一独特设计不仅有助于规避HBM资源瓶颈问题,还有助于降低成本和提升能效。

随着Groq模型和LPU处理器的崭露头角,AI计算领域正迎来新的篇章。Groq的成功不仅证明了自主研发和技术创新的重要性,也为整个行业提供了新的思考和启示。未来,我们有理由期待更多像Groq这样的创新技术,为人类社会的发展带来更多可能性。